ラグランジアンって運動方程式を求めるためにしか使ったことがない。これをオイラーラグランジュ方程式というが、そもそもラグランジアンって何かわからなかった。

答え:

それ自身には何の意味もない。(何の状態量もないという意味。)

内部の項の関係によって、取りうるパス(運動)が決定する。

運動方程式は、外力と現在の状態を入れると状態量の微分値が得られる。これは、そのラグランジアンでのパス(運動)を記述していることと同じ。具体例として、ラグランジアンがL=T-Vだと、運動エネルギをコストとおいて、ポテンシャルエナジーが植えるとコストが減ると考える。これを使い微分すると運動方程式が得られる。

簡単だけどこんな感じ、何となくだがラグランジアンというものがわかった気がしたので、覚書。

参考:

http://d.hatena.ne.jp/rikunora/20090327/p1

http://eman-physics.net/analytic/makelag.html

http://hep.ucsb.edu/people/cag/Lagrangian_Formulation.pdf

私の研究トピック(DroneとVision)で使った技術を紹介していきます。MachineLearningは興味のままで随時紹介。後は、気になるニュースを載せていきます。基本的には、タイトルに関するものを思うがまま書いていく!!

2016年11月9日水曜日

2016年11月8日火曜日

RRT* (RRT star) アルゴリズムの説明

サンプリングベースの経路探索メソッドで有名なものの一つがRRTです。RRTは経路は見つけてくれるが最適な経路を出力しない点を修正したものがRRT*です。オリジナルのRRTの説明については、Atsushiさんが素晴らしいページを作っているのでそちらを参照。RRT*の説明は日本語ではあまり見つからない(英語でもあまりなく論文を読むしかない)ので、簡単な解説です。

そもそもメリットとしては、RRT*は、最適値に収束することが保証されています(*は最適ってことみたい)。また、かなり複雑な状況でも発散せずパスを生成してくれます。しかし、最適値は無限回をしたらたどり着くよってだけで有限時間では無理。それでもいいので

さてアルゴリズムは、

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.419.5503&rep=rep1&type=pdf

4. 円の中に入っているX_near(近傍点のリスト)を作る(7)

5. x_newを点のリストVに追加(8)

そもそもメリットとしては、RRT*は、最適値に収束することが保証されています(*は最適ってことみたい)。また、かなり複雑な状況でも発散せずパスを生成してくれます。しかし、最適値は無限回をしたらたどり着くよってだけで有限時間では無理。それでもいいので

さてアルゴリズムは、

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.419.5503&rep=rep1&type=pdf

1. Add sample

2. 最も近い点を見つけて、ある距離(自分で設定)の点を打つ

3. x_newが障害物の中に入っているか?

6. 円内点と線を引き、線が障害物に接触していないかを見る+最もコストが小さい点を結ぶ。

(Connect along a minimum-cost path)

7. 新しい線を線のリスト(E)に追加

8. 円内の他とx_new に線を引き、自分の親(A)とx_newとコストを比較し、元のコストよりも小さかったら線を引き直す。

(Rewire the tree)

2016年10月20日木曜日

Googleの人工知能専門チームDeepMindがたった数カ月で40%もGoogleデータセンターの冷却システムを効率化することに成功

これすごいな。制御とDeeplearningをどう組み合わせたのか知りたい。モデルの推定?DQN等の強化学習法を使ってベストな入力を見つけたのか?この辺が誤解されるように書いてあってよくわからん。論文早くでないかな。

http://gigazine.net/news/20160721-deepmind-reduce-google-data-center-energy/

人工知能開発を行うスタートアップだった「DeepMind」は、Googleに買収された後もイギリス・ロンドンに拠点を置きつつ独自に人工知脳研究を続けています。DeepMindが開発する人工知能技術は、自己学習してゲームが上達するアルゴリズム「DQN」や囲碁の世界チャンピオンを打ち破るソフトウェア「AlphaGo」などのように時折発表されるとその度に世間を騒がせるのですが、Googleのデータセンターのエネルギー削減にも大きな威力を発揮していることが明らかになりました。

Google DeepMind

https://deepmind.com/blog

Google検索、Gmail、YouTubeなどのGoogleのさまざまなサービスを支えているのが、Googleが世界各地に持つデータセンターです。このデータセンターを効率的にすることは、Googleのサービス品質の向上につながることから、Googleはデータセンターをシステムレベルで絶えず更新し続けています。例えば、データセンターで使用するサーバーを高効率の物に置き換えたり、再生可能エネルギーで電力をまかなう取り組みが行われているとのこと。

中でもデータセンターの品質を語る上で「冷却効率」は非常に重要です。大量の熱を発生させるデータセンターを適切に冷却することはデータセンターの安定的な稼働に不可欠だからです。そして、データセンターの冷却に必要なエネルギーは、データセンターで使用されるエネルギーの大部分を占めており、冷却用のエネルギーを削減することは、環境負荷を下げることにつながります。そのためGoogleは、冷却効率を高めてエネルギーを削減することに長年取り組んでいます。なお、クラウドサービスなどでGoogleデータセンターを利用する企業にとっても、Googleのデータセンターのエネルギー削減が実現すれば、間接的な地球環境保護に役立つため、Googleはエネルギー削減に注力しているそうです。

しかし、データセンターの冷却システムは、データセンターを構成する機器があまりに複雑で非線形的に相互に影響を与えることから、机上の理論や人間の直感などを適用することが難しいという特性があります。さらに、世界中の各データセンターは環境やアーキテクチャが独自であるため、あるデータセンターに最適化された冷却モデルを他のデータセンターに適用できないという難しさもあるとのこと。そのため、データセンターの冷却システムの効率化は、ごく一般的なレベルでのフレームワークを構築するのにとどまっており、データセンターの冷却システム全体を効率化することは困難な作業と言えます。

そんなデータセンターの冷却効率化を進めるために、Googleは2年前から機械学習を取り入れてきたとのこと。機械学習によってデータセンターの使用状況を予測するモデルを立てることで、効率性を高めようというわけです。

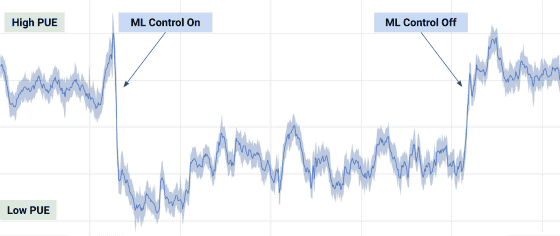

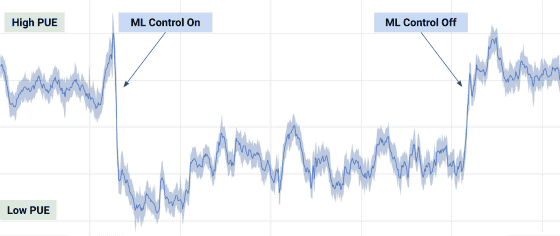

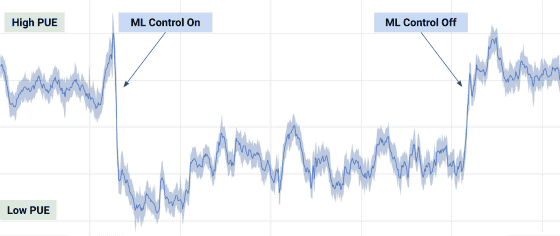

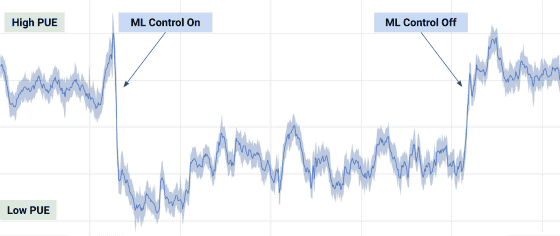

このGoogleのデータセンターの冷却システムの効率化プロジェクトに、人工知能の専門チームであるDeepMindが数カ月間参加して、データセンターチームで働いたとのこと。DeepMindチームは、すでに数千人の技術者によって収集されていたデータセンターの気温、電力、冷却ポンプ内のクーラントの流速などのデータを多層のニューラルネットワークに落とし込むディープラーニングによって解析して、効率を高めるフレームワークを作成しました。その結果、冷却システムの消費電力をコンスタントに40%削減することに成功したとのこと。これはエネルギー指標のPower Usage Effectiveness(PUE)では15%の改善に相当します。

電力使用効率のグラフでは、ML(machine learning:機械学習)をONにした状態では、電力使用効率が格段に下がっているのが確認できます。

Googleのデータセンターチームが2年間かけて機械学習によってコツコツ高めてきた冷却効率を、わずか数カ月で4割も削減するというとんでもない仕事をやってのけたDeepMindですが、複雑な変化の中から最適な条件を探し出す機械学習の手法は汎用性を持っているため、今後、数カ月かけて発電設備の効率化、半導体部分のエネルギーの削減、水使用量の削減、スループットの向上など、データセンターの別の部分の効率化に取り組む予定だそうです。

http://gigazine.net/news/20160721-deepmind-reduce-google-data-center-energy/

人工知能開発を行うスタートアップだった「DeepMind」は、Googleに買収された後もイギリス・ロンドンに拠点を置きつつ独自に人工知脳研究を続けています。DeepMindが開発する人工知能技術は、自己学習してゲームが上達するアルゴリズム「DQN」や囲碁の世界チャンピオンを打ち破るソフトウェア「AlphaGo」などのように時折発表されるとその度に世間を騒がせるのですが、Googleのデータセンターのエネルギー削減にも大きな威力を発揮していることが明らかになりました。

Google DeepMind

https://deepmind.com/blog

Google検索、Gmail、YouTubeなどのGoogleのさまざまなサービスを支えているのが、Googleが世界各地に持つデータセンターです。このデータセンターを効率的にすることは、Googleのサービス品質の向上につながることから、Googleはデータセンターをシステムレベルで絶えず更新し続けています。例えば、データセンターで使用するサーバーを高効率の物に置き換えたり、再生可能エネルギーで電力をまかなう取り組みが行われているとのこと。

中でもデータセンターの品質を語る上で「冷却効率」は非常に重要です。大量の熱を発生させるデータセンターを適切に冷却することはデータセンターの安定的な稼働に不可欠だからです。そして、データセンターの冷却に必要なエネルギーは、データセンターで使用されるエネルギーの大部分を占めており、冷却用のエネルギーを削減することは、環境負荷を下げることにつながります。そのためGoogleは、冷却効率を高めてエネルギーを削減することに長年取り組んでいます。なお、クラウドサービスなどでGoogleデータセンターを利用する企業にとっても、Googleのデータセンターのエネルギー削減が実現すれば、間接的な地球環境保護に役立つため、Googleはエネルギー削減に注力しているそうです。

しかし、データセンターの冷却システムは、データセンターを構成する機器があまりに複雑で非線形的に相互に影響を与えることから、机上の理論や人間の直感などを適用することが難しいという特性があります。さらに、世界中の各データセンターは環境やアーキテクチャが独自であるため、あるデータセンターに最適化された冷却モデルを他のデータセンターに適用できないという難しさもあるとのこと。そのため、データセンターの冷却システムの効率化は、ごく一般的なレベルでのフレームワークを構築するのにとどまっており、データセンターの冷却システム全体を効率化することは困難な作業と言えます。

そんなデータセンターの冷却効率化を進めるために、Googleは2年前から機械学習を取り入れてきたとのこと。機械学習によってデータセンターの使用状況を予測するモデルを立てることで、効率性を高めようというわけです。

このGoogleのデータセンターの冷却システムの効率化プロジェクトに、人工知能の専門チームであるDeepMindが数カ月間参加して、データセンターチームで働いたとのこと。DeepMindチームは、すでに数千人の技術者によって収集されていたデータセンターの気温、電力、冷却ポンプ内のクーラントの流速などのデータを多層のニューラルネットワークに落とし込むディープラーニングによって解析して、効率を高めるフレームワークを作成しました。その結果、冷却システムの消費電力をコンスタントに40%削減することに成功したとのこと。これはエネルギー指標のPower Usage Effectiveness(PUE)では15%の改善に相当します。

電力使用効率のグラフでは、ML(machine learning:機械学習)をONにした状態では、電力使用効率が格段に下がっているのが確認できます。

Googleのデータセンターチームが2年間かけて機械学習によってコツコツ高めてきた冷却効率を、わずか数カ月で4割も削減するというとんでもない仕事をやってのけたDeepMindですが、複雑な変化の中から最適な条件を探し出す機械学習の手法は汎用性を持っているため、今後、数カ月かけて発電設備の効率化、半導体部分のエネルギーの削減、水使用量の削減、スループットの向上など、データセンターの別の部分の効率化に取り組む予定だそうです。

2016年10月19日水曜日

Google DeepMind Natureへ3本目の論文発表「Differentiable neural computers」

GoogleのDeepMindが新しい手法を発表しました。名前は、「Differentiable neural computers」。Natureに投稿。

これで3本目です。内容としては、Deeplearningに動的に構成されるメモリを組み合わせたみたいですが、まだよくわかっていません。

これから論文よんでみよう。

詳細解ったら、追記します。

Google発表

https://deepmind.com/blog/differentiable-neural-computers/

日本でのニュース

http://ascii.jp/elem/000/001/249/1249977/

これで3本目です。内容としては、Deeplearningに動的に構成されるメモリを組み合わせたみたいですが、まだよくわかっていません。

これから論文よんでみよう。

詳細解ったら、追記します。

Google発表

https://deepmind.com/blog/differentiable-neural-computers/

日本でのニュース

http://ascii.jp/elem/000/001/249/1249977/

2016年10月14日金曜日

ディープラーニングでキュウリを選別する人工知能搭載仕分け機が開発中

すばらしい。人間で判別し難いものをディープラーニングで仕分けとは。しかも、キュウリ。面白い。ひよこの仕分けもできないかな?

http://gigazine.net/news/20160901-deep-learning-cucumber-sorter/

現在で最も華やかなコンピューター技術と言えば、ディープラーニングを用いた人工知能と言えますが、農業の分野にもそんな波は訪れようとしているようです。元制御システム開発者で、現在は家業であるキュウリ農家を営んでいる小池誠さんは、GoogleのTensorFlowを使って学習させたAIを駆使することで、収穫されたキュウリを自動で選別して等級ごとに仕分けする装置を開発しています。

【CCB9】きゅうり仕分け機試作2号機 | Workpiles

http://workpiles.com/2016/08/ccb9-prototype2-complete/

Google Cloud Platform Japan 公式ブログ: キュウリ農家とディープラーニングをつなぐ TensorFlow

http://googlecloudplatform-japan.blogspot.jp/2016/08/tensorflow_5.html

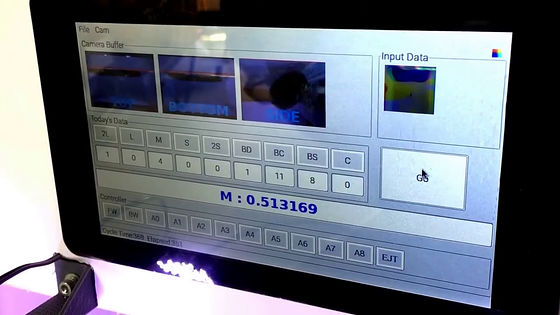

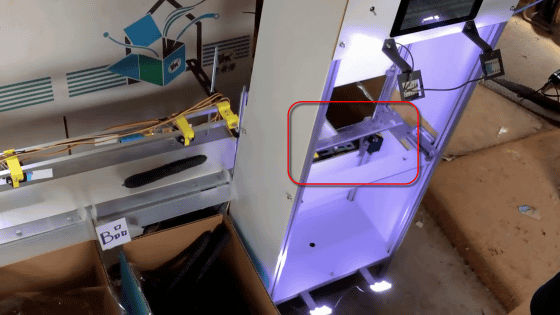

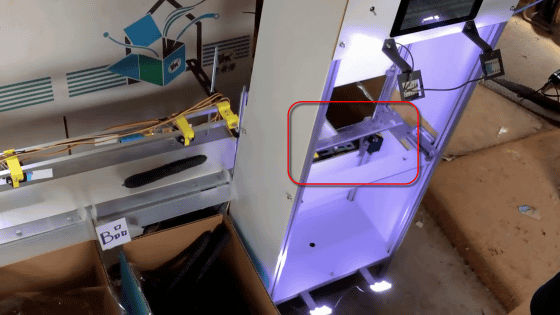

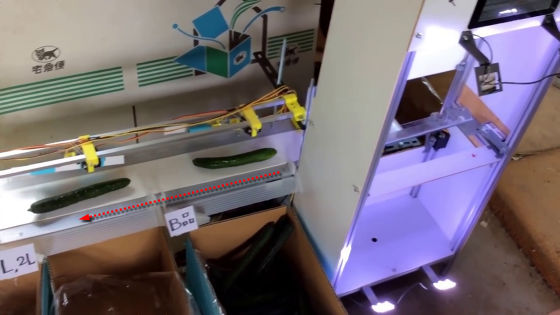

小池さんが開発した「きゅうり仕分け機」は、縦型のラックの横に仕分け用のベルトコンベアが装着されている構造。右のラックにキュウリを載せるとカメラが外観を撮影してAIが等級を判別し、ベルトコンベアで所定の段ボール箱に入れられる仕組みになっています。

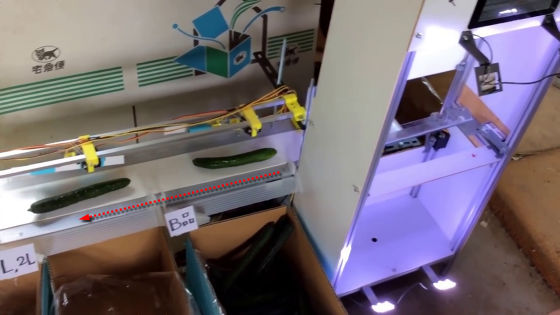

きゅうり仕分け機が実際に稼働している様子がコレ。従来ならば人の目と手で行っていた作業を、機械が自動で行う様子を見ることができます。

TensorFlow powered cucumber sorter by Makoto Koike - YouTube

キュウリを仕分け機のトレーの上に載せると……

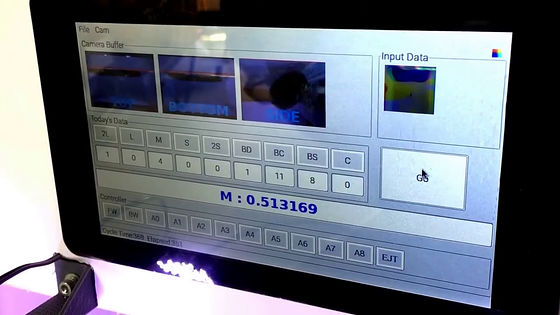

複数のカメラで撮影したキュウリの外観をもとに、どの等級に仕分けるかをAIが判断。AIには事前に何千枚ものキュウリの写真を見せ、自分で等級を見極める能力を学習させてあるそうです。

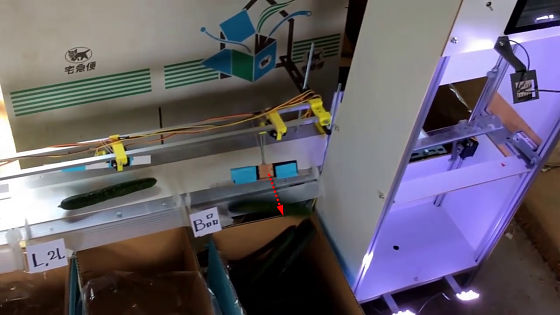

判断が終わったら、キュウリを乗せていたトレーがカタンと倒れてキュウリをベルトコンベアに落とし……

ベルトコンベアがキュウリを左へ送ります。

そして、レバーが動いてキュウリを段ボールの中にシュート。段ボールは左に行くほど等級が上がるように置かれているようで、先ほど判定されたキュウリはB級品でしたが、ベルトコンベアに残された見るからに立派なキュウリはさらに高い等級の箱に入れられることになるようです。

小池さんは、Googleの人工知能「AlphaGo (アルファ碁)」が世界最強の棋士と互角に囲碁を差し合う様子を目にして「これは凄いことが起こっている」と直感したことをきっかけに、ディープラーニングを使ったキュウリ仕分け機の開発に乗り出したとのこと。

実家がキュウリ農家を営んでいるという小池さんは、繁忙期になると1日8時間にわたって延々とキュウリの仕分けを行う母親の姿を目の当たりにします。仕分けの作業が自動化されれば、その手間を本来のキュウリ作りに向けられると考えた小池さんは、わずか4か月で試作機の完成にこぎ着けたそうです。記事作成時点では試作機の2号機が完成しているとのこと。

新鮮なキュウリ作りを信条とする小池さんの父親は「棘が刺さるキュウリ」にこだわりを持っており、表面に残る凹凸の「イボ」があるキュウリこそが品質の証しと考えているとのこと。

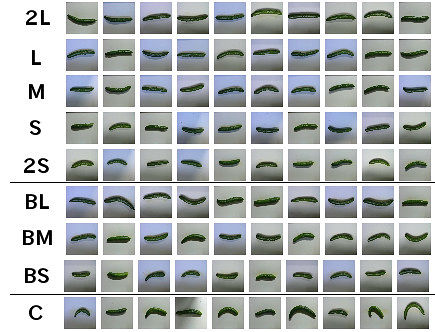

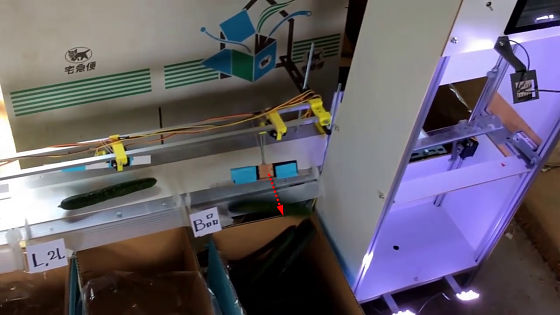

実はキュウリの等級にはこれといった規格がなく、農家が独自に判断を下しているそうです。小池さんのところでは、キュウリの太さや色、ツヤ、キズの有無などで9等級に選別を行っているとのことで、これは人間でも簡単にできる仕事ではありません。

そんな作業を自動化させるための技術として、ディープラーニングを使ったAIが用いられているというわけです。

それまでディープラーニングや機械学習に触れる機会がなかったという小池さんは、オープンソースのライブラリである「TensorFlow」を用いることからディープラーニングの世界に入ったそうです。TensorFlowはディープラーニングの実装に必要な数理モデルや最適化アルゴリズムについて熟知していなくても、公開されているサンプルやチュートリアルを用いて「とりあえず触り始める」ことができるというもので、入門用ツールとしては最適なものといえます。

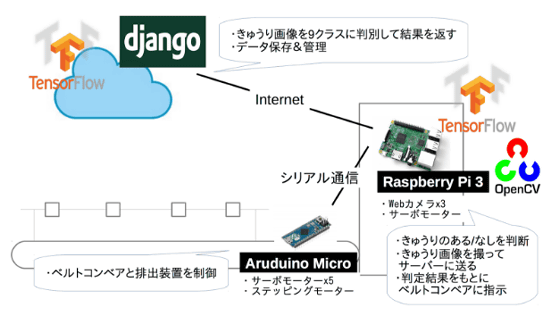

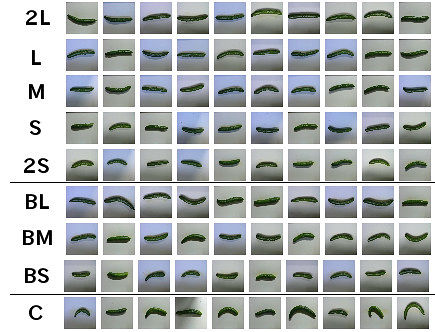

試作2号機のシステム構成は以下の通り。Webカメラによる画像撮影をRaspberry Pi 3で制御し、そこでTensorFlowによる小規模なニューラルネットによってキュウリのあり・なしを判断。そして、撮影したキュウリ画像をLinuxマシン上のTensorFlowで動作するディープラーニングによる認識エンジンに送ります。キュウリ画像の認識には、TensorFlowのサンプルコード「Deep MNIST for Experts」をベースに、若干手を加えたディープニューラルネットワークを用いているとのこと。畳み込み層とプーリング層を数回通したあと、全結合層を配置という構成で、扱う画像の解像度と分類数をキュウリ仕分け用に変更しているそうです。

現時点での判断スピードは1本あたり数秒を要している模様。さらに、学習が途上段階にあるようで、判断の正解率は70%程度ということで、改善の余地は残されている状態だそうです。しかし、これらの課題もクラウドによる分散学習でさらに多くのキュウリを学習させることで、劇的な改善が期待できるものとみられます。

かつて、農家の人々が行っていた大変な農作業を軽減させるために技術を開発したのがヤンマーなどの農機具メーカーでした。それから約1世紀がたち、21世紀の農業は以下のAlphaGoのサーバーを用いた人工知能によって負担減と効率アップが実現されるということになるのかもしれません。

なお、実際の技術の詳細などは、ページ上部の元ソースでガッツリ読み込むことが可能です。また、小池さんのキュウリ仕分け機は、Googleの英語ブログにも掲載されて世界に紹介されています。

How a Japanese cucumber farmer is using deep learning and TensorFlow | Google Cloud Big Data and Machine Learning Blog | Google Cloud Platform

https://cloud.google.com/blog/big-data/2016/08/how-a-japanese-cucumber-farmer-is-using-deep-learning-and-tensorflow

http://gigazine.net/news/20160901-deep-learning-cucumber-sorter/

現在で最も華やかなコンピューター技術と言えば、ディープラーニングを用いた人工知能と言えますが、農業の分野にもそんな波は訪れようとしているようです。元制御システム開発者で、現在は家業であるキュウリ農家を営んでいる小池誠さんは、GoogleのTensorFlowを使って学習させたAIを駆使することで、収穫されたキュウリを自動で選別して等級ごとに仕分けする装置を開発しています。

【CCB9】きゅうり仕分け機試作2号機 | Workpiles

http://workpiles.com/2016/08/ccb9-prototype2-complete/

Google Cloud Platform Japan 公式ブログ: キュウリ農家とディープラーニングをつなぐ TensorFlow

http://googlecloudplatform-japan.blogspot.jp/2016/08/tensorflow_5.html

小池さんが開発した「きゅうり仕分け機」は、縦型のラックの横に仕分け用のベルトコンベアが装着されている構造。右のラックにキュウリを載せるとカメラが外観を撮影してAIが等級を判別し、ベルトコンベアで所定の段ボール箱に入れられる仕組みになっています。

きゅうり仕分け機が実際に稼働している様子がコレ。従来ならば人の目と手で行っていた作業を、機械が自動で行う様子を見ることができます。

TensorFlow powered cucumber sorter by Makoto Koike - YouTube

キュウリを仕分け機のトレーの上に載せると……

複数のカメラで撮影したキュウリの外観をもとに、どの等級に仕分けるかをAIが判断。AIには事前に何千枚ものキュウリの写真を見せ、自分で等級を見極める能力を学習させてあるそうです。

判断が終わったら、キュウリを乗せていたトレーがカタンと倒れてキュウリをベルトコンベアに落とし……

ベルトコンベアがキュウリを左へ送ります。

そして、レバーが動いてキュウリを段ボールの中にシュート。段ボールは左に行くほど等級が上がるように置かれているようで、先ほど判定されたキュウリはB級品でしたが、ベルトコンベアに残された見るからに立派なキュウリはさらに高い等級の箱に入れられることになるようです。

小池さんは、Googleの人工知能「AlphaGo (アルファ碁)」が世界最強の棋士と互角に囲碁を差し合う様子を目にして「これは凄いことが起こっている」と直感したことをきっかけに、ディープラーニングを使ったキュウリ仕分け機の開発に乗り出したとのこと。

実家がキュウリ農家を営んでいるという小池さんは、繁忙期になると1日8時間にわたって延々とキュウリの仕分けを行う母親の姿を目の当たりにします。仕分けの作業が自動化されれば、その手間を本来のキュウリ作りに向けられると考えた小池さんは、わずか4か月で試作機の完成にこぎ着けたそうです。記事作成時点では試作機の2号機が完成しているとのこと。

新鮮なキュウリ作りを信条とする小池さんの父親は「棘が刺さるキュウリ」にこだわりを持っており、表面に残る凹凸の「イボ」があるキュウリこそが品質の証しと考えているとのこと。

実はキュウリの等級にはこれといった規格がなく、農家が独自に判断を下しているそうです。小池さんのところでは、キュウリの太さや色、ツヤ、キズの有無などで9等級に選別を行っているとのことで、これは人間でも簡単にできる仕事ではありません。

そんな作業を自動化させるための技術として、ディープラーニングを使ったAIが用いられているというわけです。

それまでディープラーニングや機械学習に触れる機会がなかったという小池さんは、オープンソースのライブラリである「TensorFlow」を用いることからディープラーニングの世界に入ったそうです。TensorFlowはディープラーニングの実装に必要な数理モデルや最適化アルゴリズムについて熟知していなくても、公開されているサンプルやチュートリアルを用いて「とりあえず触り始める」ことができるというもので、入門用ツールとしては最適なものといえます。

試作2号機のシステム構成は以下の通り。Webカメラによる画像撮影をRaspberry Pi 3で制御し、そこでTensorFlowによる小規模なニューラルネットによってキュウリのあり・なしを判断。そして、撮影したキュウリ画像をLinuxマシン上のTensorFlowで動作するディープラーニングによる認識エンジンに送ります。キュウリ画像の認識には、TensorFlowのサンプルコード「Deep MNIST for Experts」をベースに、若干手を加えたディープニューラルネットワークを用いているとのこと。畳み込み層とプーリング層を数回通したあと、全結合層を配置という構成で、扱う画像の解像度と分類数をキュウリ仕分け用に変更しているそうです。

現時点での判断スピードは1本あたり数秒を要している模様。さらに、学習が途上段階にあるようで、判断の正解率は70%程度ということで、改善の余地は残されている状態だそうです。しかし、これらの課題もクラウドによる分散学習でさらに多くのキュウリを学習させることで、劇的な改善が期待できるものとみられます。

かつて、農家の人々が行っていた大変な農作業を軽減させるために技術を開発したのがヤンマーなどの農機具メーカーでした。それから約1世紀がたち、21世紀の農業は以下のAlphaGoのサーバーを用いた人工知能によって負担減と効率アップが実現されるということになるのかもしれません。

なお、実際の技術の詳細などは、ページ上部の元ソースでガッツリ読み込むことが可能です。また、小池さんのキュウリ仕分け機は、Googleの英語ブログにも掲載されて世界に紹介されています。

How a Japanese cucumber farmer is using deep learning and TensorFlow | Google Cloud Big Data and Machine Learning Blog | Google Cloud Platform

https://cloud.google.com/blog/big-data/2016/08/how-a-japanese-cucumber-farmer-is-using-deep-learning-and-tensorflow

2016年10月7日金曜日

Ceres Solver のインストール (Windows8, Visual Studio 2013)

GoogleのCeresは非線形最適化(Non-linear Least square)として広く使われており、昨今、Visionの世界でBundle Adjustmentによく使われています。最近研究している、パスの最適化にも使えるかなってことで導入してみました。Ubuntuだともっと楽なのでしょうが、家と研究室の環境の問題から、Windowsで挑戦。

インストレーションの基本は下。

http://ceres-solver.org/building.html#windows

1. Eigen のインストール。

他のページを参照

2.Google glogのインストール

2-1. ダウンロード

以下のサイトから、glog-0.3.3.tar.gzをダウンロード。

https://code.google.com/archive/p/google-glog/downloads

アンド解凍。

2-1. コンパイル

- google-glog.slnでVisual studioを立ち上げる。

- Congifuration Manager でActive solution Platform をx64に変更する。

<New...>押してType or select the new platformをx64に変える。

また、今後のためにReleaseいしておく。

- [Build]->[Batch Build] ですべて選んでコンパイル

- しかし、エラーが。minがないとか言われる。そのため、そのエラーをクリックしたlogging.ccを立ち上げる。

インクルードならどこでもよいが、私の場合、64行目に

#include <algorithm>

を追加する。

無事エラーがなければ、コンパイル成功

3.gflagのインストール

3-1. ダウンロード

昔のバージョンが見つからないため、下記の場所から最新版をダウンロード(執筆時点2.1.2)

https://github.com/gflags/gflags

3-2. Cmake

slnがなくなっているのでcmakeでプロジェクトを作成。但し、ビルド用のフォルダの名前がbuildにすると、元からあるファイルとかぶりフォルダが作れない。そのため、もとからあるBUILDの名前を変えるか消す。

3-3. コンパイル

エラーがなければ。無事成功

4.ceres

4-1. ダウンロード

http://ceres-solver.org/

からlatest stable release をダウンロード。執筆時点1.11.0.

4-2. プロジェクトの作成

フォルダ作成ceres-bin

cmake起動

Advancedにチェックを入れるとすべてのオプションが出る。

EIGEN_INCUDE_DIR (自分のパス)/eigen-3.2.4

GLOG_INCUDE_DIR (自分のパス)/glog-0.3.3\src\windows

GLOG_LIBRARY_DIR (自分のパス)/glog-0.3.3\Release\libglog.lib

Installation GuideにはGFLAGSに関してもパスを入れなければならないとありましたが、何故か私は必要ありませんでした。

GFLAGS_INCLUDE_DIR

GFLAGS_LIBRARY_DIR

Configure & Generate

4-3. コンパイル

ceres-binの中のCeres.slnでVisual Studioを起動

[BUILD]->[BATCH BUILD]

でALL_BUILDとINSTALLのところにチェックを付けて、ビルド開始。

参考:

http://buaiso.blogspot.com/2013/12/ceres-solver-on-windows.html

http://www.rm.is.ritsumei.ac.jp/~mori/Shohei_Mori_Site/articles/installation/CeresSolver/CeresSolver.html

glogエラー解決

http://stackoverflow.com/questions/19439670/min-max-not-a-member-of-std-errors-when-building-opencv-2-4-6-on-windows-8

インストレーションの基本は下。

http://ceres-solver.org/building.html#windows

1. Eigen のインストール。

他のページを参照

2.Google glogのインストール

2-1. ダウンロード

以下のサイトから、glog-0.3.3.tar.gzをダウンロード。

https://code.google.com/archive/p/google-glog/downloads

アンド解凍。

2-1. コンパイル

- google-glog.slnでVisual studioを立ち上げる。

- Congifuration Manager でActive solution Platform をx64に変更する。

<New...>押してType or select the new platformをx64に変える。

また、今後のためにReleaseいしておく。

- [Build]->[Batch Build] ですべて選んでコンパイル

- しかし、エラーが。minがないとか言われる。そのため、そのエラーをクリックしたlogging.ccを立ち上げる。

インクルードならどこでもよいが、私の場合、64行目に

#include <algorithm>

を追加する。

無事エラーがなければ、コンパイル成功

3.gflagのインストール

3-1. ダウンロード

昔のバージョンが見つからないため、下記の場所から最新版をダウンロード(執筆時点2.1.2)

https://github.com/gflags/gflags

3-2. Cmake

slnがなくなっているのでcmakeでプロジェクトを作成。但し、ビルド用のフォルダの名前がbuildにすると、元からあるファイルとかぶりフォルダが作れない。そのため、もとからあるBUILDの名前を変えるか消す。

3-3. コンパイル

エラーがなければ。無事成功

4.ceres

4-1. ダウンロード

http://ceres-solver.org/

からlatest stable release をダウンロード。執筆時点1.11.0.

4-2. プロジェクトの作成

フォルダ作成ceres-bin

cmake起動

Advancedにチェックを入れるとすべてのオプションが出る。

EIGEN_INCUDE_DIR (自分のパス)/eigen-3.2.4

GLOG_INCUDE_DIR (自分のパス)/glog-0.3.3\src\windows

GLOG_LIBRARY_DIR (自分のパス)/glog-0.3.3\Release\libglog.lib

Installation GuideにはGFLAGSに関してもパスを入れなければならないとありましたが、何故か私は必要ありませんでした。

GFLAGS_INCLUDE_DIR

GFLAGS_LIBRARY_DIR

4-3. コンパイル

ceres-binの中のCeres.slnでVisual Studioを起動

[BUILD]->[BATCH BUILD]

でALL_BUILDとINSTALLのところにチェックを付けて、ビルド開始。

参考:

http://buaiso.blogspot.com/2013/12/ceres-solver-on-windows.html

http://www.rm.is.ritsumei.ac.jp/~mori/Shohei_Mori_Site/articles/installation/CeresSolver/CeresSolver.html

glogエラー解決

http://stackoverflow.com/questions/19439670/min-max-not-a-member-of-std-errors-when-building-opencv-2-4-6-on-windows-8

2016年10月6日木曜日

Google Open SLAM 発表

GoogleのOpenSourceのSLAMを発表した。複合センサって、これスゲーな。とりあえず、最近の研究成果が全部反映されてる感じがする。もっと詳しく読んでみて、中身を追ってみるべきだな。

https://opensource.googleblog.com/2016/10/introducing-cartographer.html

https://opensource.googleblog.com/2016/10/introducing-cartographer.html

3D

2D

2016年9月30日金曜日

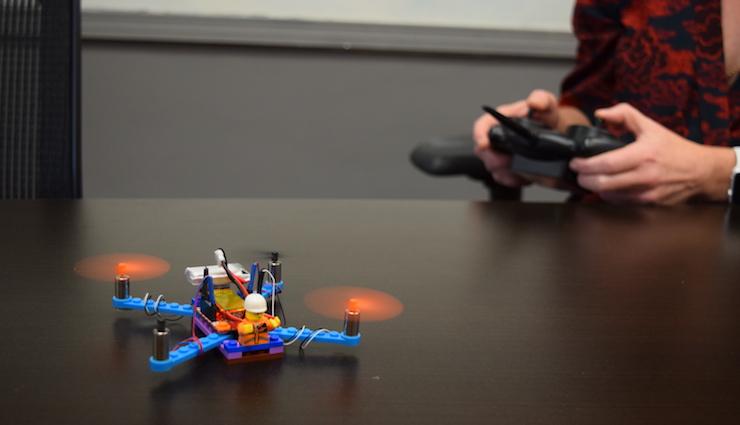

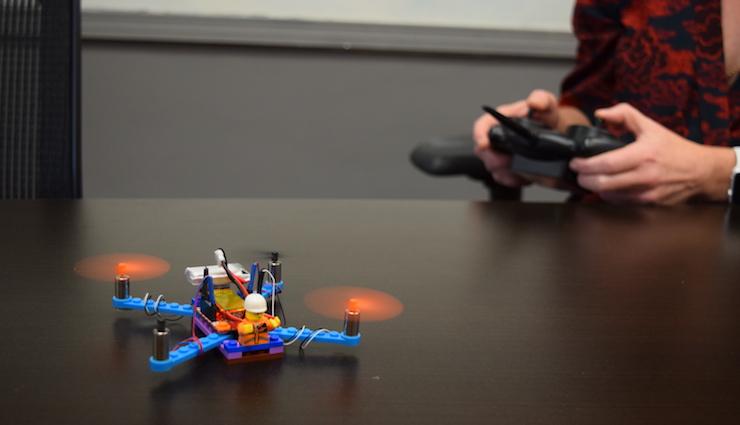

LEGO、空を飛ぶ。自作LEGOをドローン化するキットが販売開始。15分で完成、壊れてもいい設計

これすごい。発想は単純だけど、コントローラとかセンサは何使ってるんだろう。買ってみようかな。

https://flybrix.com/

http://japanese.engadget.com/2016/09/27/lego-15/

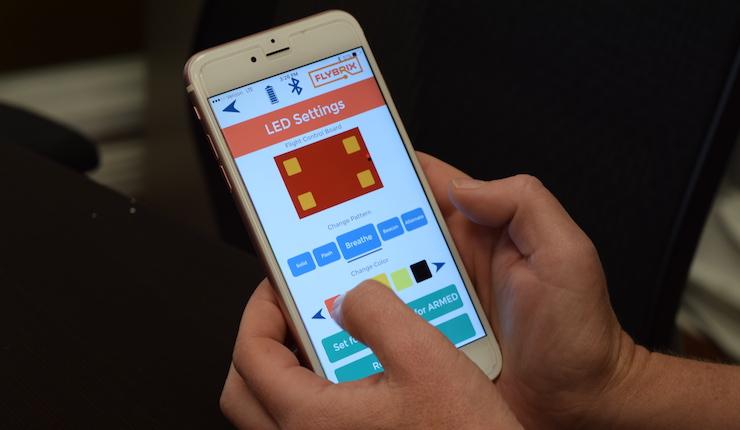

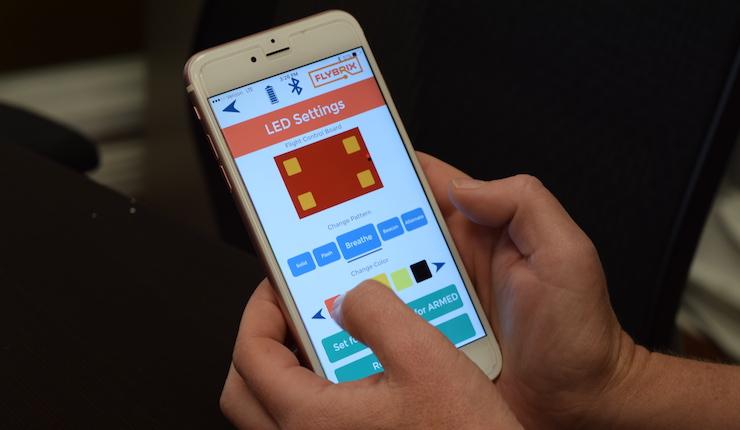

サンフランシスコのスタートアップが、レゴを使ってドローンを自作できるキットを発売しました。基本キットにはレゴのセットやモーター、プロペラにオープンソースのコントロール基板、それにAndroid/iOS/PC用アプリが付属し、Bluetooth経由で操作ができます。

レゴは子供から大人まで親しまれ、なんでもできる万能のツール。プロのデザイナーや研究者が構想を固めるために使うこともよくあり、最近は本格的なロボットが作成できる「WeDo2.0」も発売されましたが、また新たな可能性が広がりました。

このキットを発表したのは、2005年に創業したスタートアップのFlybrix。そのチーフ・プレイ・オフィサーを務めるHolly Kasun氏は「これはただの玩具ではなく、世界で最も普及したブロックを用いた教育ツールです」と語っています。

この製品を使えば、たった15分でクアッド(4つのプロペラ)やヘキサ(6つ)、オクタ(8つ)コプターを組み立てることが可能です。もう一つの特徴は「壊れてもいい」設計であること。墜落して壊れても、ブロックやパーツを拾い集めてまた組み立て直せばいいだけのお手軽さ。

サンフランシスコで開かれた製品デモに参加したメディア関係者によると、組み立てたレゴドローンは離陸した数秒後には落ちてしまったそうです。が、そうした「壊してもすぐやり直せる」のがこの製品のいいところ。Kasun氏は、ゆくゆくは学校の授業に採用され、教師の指導のもとで電子エンジニアリング教育に使われる展望を語っています。

製品には10本のゲームを含むソフトが同梱され、直接コントローラーで操作するほか、プログラムによる自動操縦もでき、むしろ大人が楽しめそうなパッケージとなっています。

YouTubeには公式プロモ動画が公開されており、ガレージに工房をかまえる二人の少年が『爆走兄弟レッツ&ゴー!!』のミニ四駆改造ばりにトライアンドエラー。お菓子を口に運ばせたり、大きなブロックを運ばせたりと想像力を無限に羽ばたかせています。

すでに公式サイトで販売しており、基本セットは期間限定で149ドル=約1万5千円(通常価格は189ドル=約1万9千円)、リモコン付属のデラックス版が189ドル=約1万9千円(同249ドル=約2万5千円)。ぎりぎり趣味の範囲に収まりそうな価格も魅力です。

https://flybrix.com/

http://japanese.engadget.com/2016/09/27/lego-15/

サンフランシスコのスタートアップが、レゴを使ってドローンを自作できるキットを発売しました。基本キットにはレゴのセットやモーター、プロペラにオープンソースのコントロール基板、それにAndroid/iOS/PC用アプリが付属し、Bluetooth経由で操作ができます。

このキットを発表したのは、2005年に創業したスタートアップのFlybrix。そのチーフ・プレイ・オフィサーを務めるHolly Kasun氏は「これはただの玩具ではなく、世界で最も普及したブロックを用いた教育ツールです」と語っています。

この製品を使えば、たった15分でクアッド(4つのプロペラ)やヘキサ(6つ)、オクタ(8つ)コプターを組み立てることが可能です。もう一つの特徴は「壊れてもいい」設計であること。墜落して壊れても、ブロックやパーツを拾い集めてまた組み立て直せばいいだけのお手軽さ。

サンフランシスコで開かれた製品デモに参加したメディア関係者によると、組み立てたレゴドローンは離陸した数秒後には落ちてしまったそうです。が、そうした「壊してもすぐやり直せる」のがこの製品のいいところ。Kasun氏は、ゆくゆくは学校の授業に採用され、教師の指導のもとで電子エンジニアリング教育に使われる展望を語っています。

製品には10本のゲームを含むソフトが同梱され、直接コントローラーで操作するほか、プログラムによる自動操縦もでき、むしろ大人が楽しめそうなパッケージとなっています。

YouTubeには公式プロモ動画が公開されており、ガレージに工房をかまえる二人の少年が『爆走兄弟レッツ&ゴー!!』のミニ四駆改造ばりにトライアンドエラー。お菓子を口に運ばせたり、大きなブロックを運ばせたりと想像力を無限に羽ばたかせています。

すでに公式サイトで販売しており、基本セットは期間限定で149ドル=約1万5千円(通常価格は189ドル=約1万9千円)、リモコン付属のデラックス版が189ドル=約1万9千円(同249ドル=約2万5千円)。ぎりぎり趣味の範囲に収まりそうな価格も魅力です。

2016年8月29日月曜日

Googleの人工知能専門チームDeepMindがたった数カ月で40%もGoogleデータセンターの冷却システムを効率化することに成功

これすごいな。制御とDeeplearningをどう組み合わせたのか知りたい。論文早くでないかな。

http://gigazine.net/news/20160721-deepmind-reduce-google-data-center-energy/

人工知能開発を行うスタートアップだった「DeepMind」は、Googleに買収された後もイギリス・ロンドンに拠点を置きつつ独自に人工知脳研究を続けています。DeepMindが開発する人工知能技術は、自己学習してゲームが上達するアルゴリズム「DQN」や囲碁の世界チャンピオンを打ち破るソフトウェア「AlphaGo」などのように時折発表されるとその度に世間を騒がせるのですが、Googleのデータセンターのエネルギー削減にも大きな威力を発揮していることが明らかになりました。

Google DeepMind

https://deepmind.com/blog

Google検索、Gmail、YouTubeなどのGoogleのさまざまなサービスを支えているのが、Googleが世界各地に持つデータセンターです。このデータセンターを効率的にすることは、Googleのサービス品質の向上につながることから、Googleはデータセンターをシステムレベルで絶えず更新し続けています。例えば、データセンターで使用するサーバーを高効率の物に置き換えたり、再生可能エネルギーで電力をまかなう取り組みが行われているとのこと。

中でもデータセンターの品質を語る上で「冷却効率」は非常に重要です。大量の熱を発生させるデータセンターを適切に冷却することはデータセンターの安定的な稼働に不可欠だからです。そして、データセンターの冷却に必要なエネルギーは、データセンターで使用されるエネルギーの大部分を占めており、冷却用のエネルギーを削減することは、環境負荷を下げることにつながります。そのためGoogleは、冷却効率を高めてエネルギーを削減することに長年取り組んでいます。なお、クラウドサービスなどでGoogleデータセンターを利用する企業にとっても、Googleのデータセンターのエネルギー削減が実現すれば、間接的な地球環境保護に役立つため、Googleはエネルギー削減に注力しているそうです。

しかし、データセンターの冷却システムは、データセンターを構成する機器があまりに複雑で非線形的に相互に影響を与えることから、机上の理論や人間の直感などを適用することが難しいという特性があります。さらに、世界中の各データセンターは環境やアーキテクチャが独自であるため、あるデータセンターに最適化された冷却モデルを他のデータセンターに適用できないという難しさもあるとのこと。そのため、データセンターの冷却システムの効率化は、ごく一般的なレベルでのフレームワークを構築するのにとどまっており、データセンターの冷却システム全体を効率化することは困難な作業と言えます。

そんなデータセンターの冷却効率化を進めるために、Googleは2年前から機械学習を取り入れてきたとのこと。機械学習によってデータセンターの使用状況を予測するモデルを立てることで、効率性を高めようというわけです。

このGoogleのデータセンターの冷却システムの効率化プロジェクトに、人工知能の専門チームであるDeepMindが数カ月間参加して、データセンターチームで働いたとのこと。DeepMindチームは、すでに数千人の技術者によって収集されていたデータセンターの気温、電力、冷却ポンプ内のクーラントの流速などのデータを多層のニューラルネットワークに落とし込むディープラーニングによって解析して、効率を高めるフレームワークを作成しました。その結果、冷却システムの消費電力をコンスタントに40%削減することに成功したとのこと。これはエネルギー指標のPower Usage Effectiveness(PUE)では15%の改善に相当します。

電力使用効率のグラフでは、ML(machine learning:機械学習)をONにした状態では、電力使用効率が格段に下がっているのが確認できます。

Googleのデータセンターチームが2年間かけて機械学習によってコツコツ高めてきた冷却効率を、わずか数カ月で4割も削減するというとんでもない仕事をやってのけたDeepMindですが、複雑な変化の中から最適な条件を探し出す機械学習の手法は汎用性を持っているため、今後、数カ月かけて発電設備の効率化、半導体部分のエネルギーの削減、水使用量の削減、スループットの向上など、データセンターの別の部分の効率化に取り組む予定だそうです。

http://gigazine.net/news/20160721-deepmind-reduce-google-data-center-energy/

人工知能開発を行うスタートアップだった「DeepMind」は、Googleに買収された後もイギリス・ロンドンに拠点を置きつつ独自に人工知脳研究を続けています。DeepMindが開発する人工知能技術は、自己学習してゲームが上達するアルゴリズム「DQN」や囲碁の世界チャンピオンを打ち破るソフトウェア「AlphaGo」などのように時折発表されるとその度に世間を騒がせるのですが、Googleのデータセンターのエネルギー削減にも大きな威力を発揮していることが明らかになりました。

Google DeepMind

https://deepmind.com/blog

Google検索、Gmail、YouTubeなどのGoogleのさまざまなサービスを支えているのが、Googleが世界各地に持つデータセンターです。このデータセンターを効率的にすることは、Googleのサービス品質の向上につながることから、Googleはデータセンターをシステムレベルで絶えず更新し続けています。例えば、データセンターで使用するサーバーを高効率の物に置き換えたり、再生可能エネルギーで電力をまかなう取り組みが行われているとのこと。

中でもデータセンターの品質を語る上で「冷却効率」は非常に重要です。大量の熱を発生させるデータセンターを適切に冷却することはデータセンターの安定的な稼働に不可欠だからです。そして、データセンターの冷却に必要なエネルギーは、データセンターで使用されるエネルギーの大部分を占めており、冷却用のエネルギーを削減することは、環境負荷を下げることにつながります。そのためGoogleは、冷却効率を高めてエネルギーを削減することに長年取り組んでいます。なお、クラウドサービスなどでGoogleデータセンターを利用する企業にとっても、Googleのデータセンターのエネルギー削減が実現すれば、間接的な地球環境保護に役立つため、Googleはエネルギー削減に注力しているそうです。

しかし、データセンターの冷却システムは、データセンターを構成する機器があまりに複雑で非線形的に相互に影響を与えることから、机上の理論や人間の直感などを適用することが難しいという特性があります。さらに、世界中の各データセンターは環境やアーキテクチャが独自であるため、あるデータセンターに最適化された冷却モデルを他のデータセンターに適用できないという難しさもあるとのこと。そのため、データセンターの冷却システムの効率化は、ごく一般的なレベルでのフレームワークを構築するのにとどまっており、データセンターの冷却システム全体を効率化することは困難な作業と言えます。

そんなデータセンターの冷却効率化を進めるために、Googleは2年前から機械学習を取り入れてきたとのこと。機械学習によってデータセンターの使用状況を予測するモデルを立てることで、効率性を高めようというわけです。

このGoogleのデータセンターの冷却システムの効率化プロジェクトに、人工知能の専門チームであるDeepMindが数カ月間参加して、データセンターチームで働いたとのこと。DeepMindチームは、すでに数千人の技術者によって収集されていたデータセンターの気温、電力、冷却ポンプ内のクーラントの流速などのデータを多層のニューラルネットワークに落とし込むディープラーニングによって解析して、効率を高めるフレームワークを作成しました。その結果、冷却システムの消費電力をコンスタントに40%削減することに成功したとのこと。これはエネルギー指標のPower Usage Effectiveness(PUE)では15%の改善に相当します。

電力使用効率のグラフでは、ML(machine learning:機械学習)をONにした状態では、電力使用効率が格段に下がっているのが確認できます。

Googleのデータセンターチームが2年間かけて機械学習によってコツコツ高めてきた冷却効率を、わずか数カ月で4割も削減するというとんでもない仕事をやってのけたDeepMindですが、複雑な変化の中から最適な条件を探し出す機械学習の手法は汎用性を持っているため、今後、数カ月かけて発電設備の効率化、半導体部分のエネルギーの削減、水使用量の削減、スループットの向上など、データセンターの別の部分の効率化に取り組む予定だそうです。

2016年7月15日金曜日

イタチゴッコ

http://kivantium.hateblo.jp/

顔認識を失敗させる眼鏡も面白いが、

ご紹介まで。

2016年6月24日金曜日

完全な自動化で操縦はもちろん充電・バッテリー交換作業すら不要のビジネス向けドローンシステム「Airobotics」

充電が自動が面白いかな。最初のパスプランニングは多分手動だろう。http://gigazine.net/news/20160622-airobotics/

ドローンは娯楽向け以上にビジネス用途での活用が期待されていますが、大きな障害となるのがドローンをコントロールする技術的な難しさです。そこで、ビジネスでドローンを活用するべく、誰でも簡単に使え、人間の手を一切煩わせることなく「完全な自動化」を実現するドローンシステム「Airobotics」が開発されています。

Airobotics

http://www.airobotics.co.il/

完全自動化のドローンシステムAiroboticsについては、以下のムービーを見れば一発で理解できます。

Airobotics - Automated Industrial Drones - YouTube

「Airoboticsはドローン産業に革命を起こします」と語るのは、Airoboticsのラン・クラウスCEO。

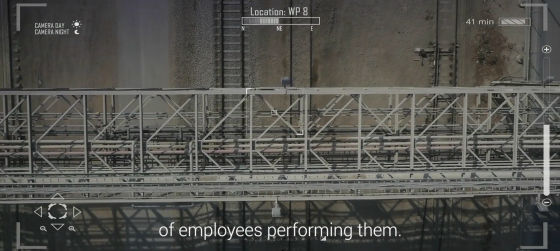

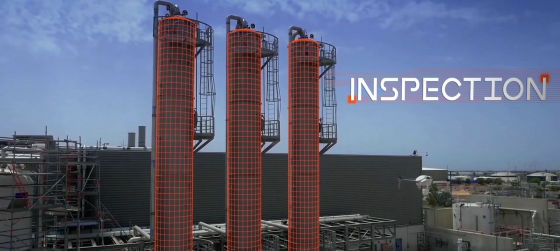

ここは採掘施設。

採掘場のような広大で危険がつきものの現場でドローンが果たす役割は大きくなりつつあるとのこと。

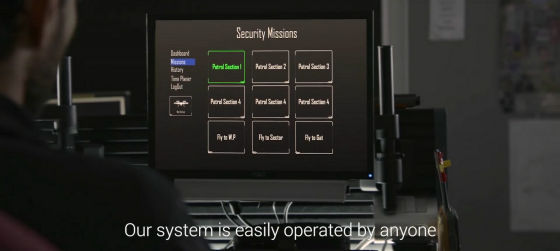

ドローンが担う作業として、まずは定期的な巡回作業があります。

設備が機能し作業員が正しく働いているかをチェックするのに、空中から確認できるドローンは最適。

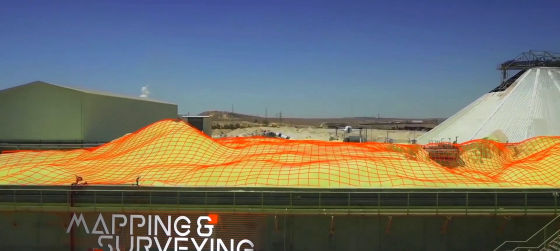

空中から俯瞰(ふかん)できるドローンならではの活用法もあり。

それはマッピングや測量。空中から撮影した映像をソフトウェアで処理することで、これまでは多くの人手が必要だった測量作業を効率的に行うことができます。

「この施設には100台のセキュリティカメラがあります」と話すクラウスCEO。

工場ではセキュリティチェックのために、2台の自動車が巡回していますが、警備にもドローンは活用できます。

ドローンの映像は、遠隔地からリアルタイムで確認可能。警備する人の負担を大きく軽減できます。

「また、このような施設内には、危険なエリアが多数存在します」

危険な場所に人を派遣することなく、無人で調査できるドローンは、危険なエリアの探索にも心強い存在です。

「このような施設でのドローンの活用は進んできていますが……」

「ドローン専門の業者に外注するには高いコストがかかります」

「また、社内でドローンを扱う人材を育てるにもお金がかかり、その上、望むような結果が得られないというリスクもあります」

このようなビジネス用のドローンを、低価格で利用できるのがAiroboticsのドローンシステム。

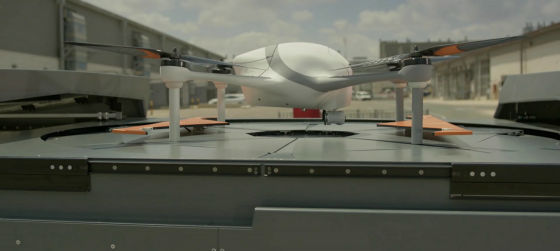

クラウスCEOの後ろにあるプレハブの建物くらいの物体は、Airoboticsの開発した「ドローンベース」とのこと。あらゆるニーズに正確に応えるために開発されたドローンの本拠地で、屋外に設営できます。

屋根の部分が左右に開くと……

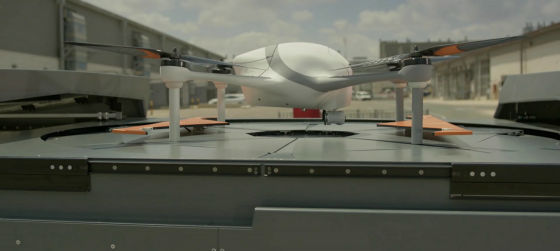

中からヘリポートのような「ドローンポート」が登場。

こんな形のクアッドコプターを使います。

このドローンベースはドローンが離発着する拠点となる施設。

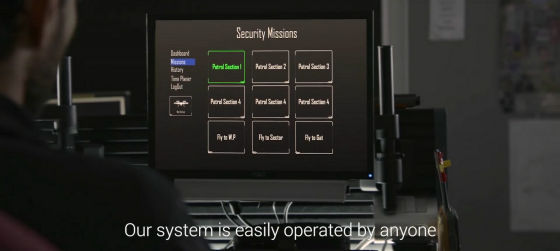

Airoboticsはドローンベースと共に、ドローンを管理するためのソフトウェアシステムを提供するとのこと。

Airoboticsシステム最大のウリは、「完全なる自動化」

一般的なドローンは、姿勢制御は自動化されていますが飛行コントロールは人間が行い、また、長時間の飛行に避けて通れない充電やバッテリー交換は手作業で行う必要があります。

しかし、Airoboticsのドローンシステムでは、飛行プログラムに従ってドローンが全自動で離陸、飛行、着陸することができ、充電作業すら不要の完全な自動化を実現しています。

ドローンの飛行コントロールは一切不要で、遠隔地からモニター越しにドローンの飛行状況を確認可能。人間がやることは、ドローンに与えられたミッションが確実にこなされているのかのチェックのみ。

予定のミッションを終えてドローンベースに戻ってきたドローン。

所定の場所に着陸。もちろん全自動。

ドローンが着陸すると、ロボットアームがバッテリーを運びます。

そして、ドローン本体にバッテリーを挿入。ドローンのバッテリー交換作業も完全自動化されています。

エネルギー補給完了。

バッテリーを交換したドローンは、次のミッションに向けて飛び立ちました。

Airoboticsのドローンシステムでは、「セキュリティ」や……

「巡回作業」

「測量」

「緊急時の現場確認作業」などを、人間の手を煩わせることなくドローンに担わせることが可能です。

「完全な全自動化」によって、ドローンビジネスは大きく変わるとAiroboticsは考えています。

Airoboticsは、イスラエル・テルアビブに本拠を構える2014年7月創業のスタートアップで、GoogleのATAPチームのリチャード・ウルドリッジCOOやUpWest Labsなどから、2850万ドル(約30億円)の出資を獲得しています。シリーズBの投資ラウンドを経たAiroboticsは、完全自動ドローンシステムの市販に向けて動き出すことになりそうです。

ドローンは娯楽向け以上にビジネス用途での活用が期待されていますが、大きな障害となるのがドローンをコントロールする技術的な難しさです。そこで、ビジネスでドローンを活用するべく、誰でも簡単に使え、人間の手を一切煩わせることなく「完全な自動化」を実現するドローンシステム「Airobotics」が開発されています。

Airobotics

http://www.airobotics.co.il/

完全自動化のドローンシステムAiroboticsについては、以下のムービーを見れば一発で理解できます。

Airobotics - Automated Industrial Drones - YouTube

「Airoboticsはドローン産業に革命を起こします」と語るのは、Airoboticsのラン・クラウスCEO。

ここは採掘施設。

採掘場のような広大で危険がつきものの現場でドローンが果たす役割は大きくなりつつあるとのこと。

ドローンが担う作業として、まずは定期的な巡回作業があります。

設備が機能し作業員が正しく働いているかをチェックするのに、空中から確認できるドローンは最適。

空中から俯瞰(ふかん)できるドローンならではの活用法もあり。

それはマッピングや測量。空中から撮影した映像をソフトウェアで処理することで、これまでは多くの人手が必要だった測量作業を効率的に行うことができます。

「この施設には100台のセキュリティカメラがあります」と話すクラウスCEO。

工場ではセキュリティチェックのために、2台の自動車が巡回していますが、警備にもドローンは活用できます。

ドローンの映像は、遠隔地からリアルタイムで確認可能。警備する人の負担を大きく軽減できます。

「また、このような施設内には、危険なエリアが多数存在します」

危険な場所に人を派遣することなく、無人で調査できるドローンは、危険なエリアの探索にも心強い存在です。

「このような施設でのドローンの活用は進んできていますが……」

「ドローン専門の業者に外注するには高いコストがかかります」

「また、社内でドローンを扱う人材を育てるにもお金がかかり、その上、望むような結果が得られないというリスクもあります」

このようなビジネス用のドローンを、低価格で利用できるのがAiroboticsのドローンシステム。

クラウスCEOの後ろにあるプレハブの建物くらいの物体は、Airoboticsの開発した「ドローンベース」とのこと。あらゆるニーズに正確に応えるために開発されたドローンの本拠地で、屋外に設営できます。

屋根の部分が左右に開くと……

中からヘリポートのような「ドローンポート」が登場。

こんな形のクアッドコプターを使います。

このドローンベースはドローンが離発着する拠点となる施設。

Airoboticsはドローンベースと共に、ドローンを管理するためのソフトウェアシステムを提供するとのこと。

Airoboticsシステム最大のウリは、「完全なる自動化」

一般的なドローンは、姿勢制御は自動化されていますが飛行コントロールは人間が行い、また、長時間の飛行に避けて通れない充電やバッテリー交換は手作業で行う必要があります。

しかし、Airoboticsのドローンシステムでは、飛行プログラムに従ってドローンが全自動で離陸、飛行、着陸することができ、充電作業すら不要の完全な自動化を実現しています。

ドローンの飛行コントロールは一切不要で、遠隔地からモニター越しにドローンの飛行状況を確認可能。人間がやることは、ドローンに与えられたミッションが確実にこなされているのかのチェックのみ。

予定のミッションを終えてドローンベースに戻ってきたドローン。

所定の場所に着陸。もちろん全自動。

ドローンが着陸すると、ロボットアームがバッテリーを運びます。

そして、ドローン本体にバッテリーを挿入。ドローンのバッテリー交換作業も完全自動化されています。

エネルギー補給完了。

バッテリーを交換したドローンは、次のミッションに向けて飛び立ちました。

Airoboticsのドローンシステムでは、「セキュリティ」や……

「巡回作業」

「測量」

「緊急時の現場確認作業」などを、人間の手を煩わせることなくドローンに担わせることが可能です。

「完全な全自動化」によって、ドローンビジネスは大きく変わるとAiroboticsは考えています。

Airoboticsは、イスラエル・テルアビブに本拠を構える2014年7月創業のスタートアップで、GoogleのATAPチームのリチャード・ウルドリッジCOOやUpWest Labsなどから、2850万ドル(約30億円)の出資を獲得しています。シリーズBの投資ラウンドを経たAiroboticsは、完全自動ドローンシステムの市販に向けて動き出すことになりそうです。

登録:

コメント (Atom)